Die Vorteile von Cloud für Unternehmen jeder Größe und Branche sind hinreichend bekannt. Besonders das Krisenjahr hat gezeigt: erst mit der Cloud ist die digitale Transformation machbar. Doch ganz so einfach ist es nicht. Unternehmen brauchen erst eine durchdachte Datenstrategie und die passende Plattform.

Source: Cloud ja, aber bitte mit Plan!

Im letzten Jahr wurden Digitalisierungsprojekte in ungeahnter Geschwindigkeit umgesetzt, teils in nur wenigen Wochen. Dabei spielt die Cloud eine bedeutende Rolle, um schnell auf sich verändernde IT- und Kundenbedürfnisse zu reagieren. So sind SaaS-Apps normalerweise einfacher einzurichten, zu verwenden und zu verwalten als lokale IT-Systeme. Und auch das Skalieren von Cloud-Services ist einfacher als der Kauf und die Einrichtung neuer Hardware.

Unternehmen erhalten durch die Auslagerung von Services in die Cloud die Möglichkeit, mehr Zeit und Ressourcen in den Ausbau ihres Geschäfts zu investieren und Entwicklungen schneller voranzutreiben. Leider ist die Migration in die Cloud oft komplexer als gedacht, denn einige Apps und Services existieren weiterhin ausschließlich lokal, während andere in die Cloud-Infrastruktur ausgelagert werden können. Viele, vor allem geschäftskritische Anwendungen, müssen jedoch grundlegend neugestaltet oder ausgetauscht werden, um sie in der neuen, dezentralen Welt nutzbar zu machen – ein nicht zu unterschätzender Aufwand, der Zeit und Sorgfalt erfordert.

Die Migration in die Cloud beschäftigt gesamtes IT-Team

Diverse Herausforderungen müssen gemeistert werden, denn die Unternehmen müssen ihre verschiedenen Systeme so umfassend miteinander verknüpfen, wie nie zuvor – inklusive zahlreicher neuer Abhängigkeiten und Codeänderungen und das quasi in Echtzeit. All das erfordert DevOps-Entwickler, die auf Abruf zur Verfügung stehen und komplexe Anwendungen mit bis zu Tausenden voneinander abhängigen Micro-Services managen müssen. Auch für die Sicherheit soll gesorgt werden, nicht nur lokal, sondern über eine immer größere Zahl von Standorten, Fremdanwendungen und Geräten hinweg.

Schon kleine Fehler in diesem Konstrukt können dazu führen, dass die Kosten ausufern oder – noch schlimmer – dass es zu Systemabstürzen kommt, bis hin zum Totalausfall des Unternehmens. Unternehmen brauchen daher eine klare Strategie, um der Komplexität einer Cloud-Migration zu managen. Die Grundlage dieser Strategie bilden die eigenen Maschinendaten. Daten werden zwar fortlaufend erhoben, oft jedoch nicht gewinnbringend genutzt. Zudem sind Daten heute zumeist über viele Systeme und Endpunkte verstreut. Mit der richtigen Datenplattform kann die IT-Abteilung jedoch Ordnung in ihre Datenflut bringen.

Datenplattform skaliert nach Bedarf

Die ideale Datenplattform funktioniert unabhängig davon, wie weit die Cloud-Migration im Unternehmen bereits vorangeschritten ist. Zudem skaliert sie je nach Bedarf, um den wachsenden Anforderungen der Organisation gerecht zu werden. Ein effektiver Schutz des Datenflusses von der lokalen Infrastruktur über die Cloud-Infrastruktur bis hin zu Cloud-basierten Anwendungen und Services ist ebenfalls essenziell. Mit einer Datenplattform wie der Data-to-Everything Plattform von Splunk können Unternehmen ihre Ausgaben in Echtzeit überwachen, Kosten prognostizieren und Ineffizienzen erkennen.

Kurz: Unternehmen profitieren von den enormen Kostenvorteilen der Cloud. Sicherheits- und IT-Teams nutzen Remotelösungen, um die Produktivität und Services in sich ändernden globalen Herausforderungen sicherzustellen. DevOps-Teams verbessern ihre Innovationsrate erheblich und sorgen für ein verbessertes Nutzererlebnis. Eine gute Datenplattform vereint die verschiedenen Datenquellen über jeden gewünschten Zeitraum und ermöglicht so höchste Transparenz und volle Kontrolle aller Daten.

Die richtige Plattform verbindet technische und geschäftliche Informationen richtig miteinander und verwandelt ungenutzte Daten in wertvolle Informationen, die das Geschäftsziel unterstützen. Studien zeigen, dass eine reife Datenstrategie positive Auswirkungen hat und zu mehr Umsatz, geringeren Betriebskosten, mehr Innovationen, schnelleren Markteinführungen sowie zu besserer Kundenzufriedenheit und -loyalität führt.

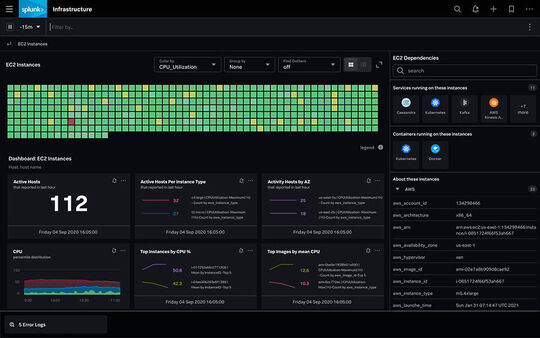

Observability in der Cloud

Die Cloud bedeutet auch eine Herausforderung für das Monitoring. Herkömmliches Monitoring-Tools sind mit der schieren Menge an Services, Anwendungen und Infrastrukturänderungen überfordert und können diese nicht verwalten. Eine Anwendung, die aus Tausenden lose gekoppelter Microservices und serverlosen Funktionen besteht, die in mehreren lokalen und Cloud-Umgebungen bestehen, lässt sich mit klassischem Monitoring nicht überwachen.

Zudem legen sie den Schwerpunkt auf bereits bekannte Gefahren. Wichtig für IT-Teams sind jedoch die noch unbekannten Gefahren. Das kann Observability leisten. Diese „Beobachtbarkeit“ wird durch die umfassende Analyse, Zusammenfassung und Darstellung aller Cloud-spezifischen Metriken, Traces und Logs überhaupt erst möglich. Und nur so wird quasi in Echtzeit erkennbar, wann, wo und warum ein Problem auftritt oder voraussichtlich auftreten wird. Sicherheits-, IT Operations- und DevOps-Teams können etwa in der Observability Cloud alle relevanten Daten überwachen, analysieren und bei Bedarf entsprechende Maßnahmen ergreifen. So können sie beispielsweise Nachfragespitzen rasch bewältigen und technische Probleme sowie mögliche Sicherheitsbedrohungen unmittelbar beseitigen.

Splunk-Kunde Lenovo nutzt die Observability Cloud für die eigene Website und hat besonders beim letzten Black Friday einen klaren Unterschied gesehen, wie uns Ben Leong, Director of Online & Ecommerce Operations bei Lenovo bestätigt: Durch Splunk Observability sei die Mean-Time-to-Resolution (MTTR) von 30 auf unter 5 Minuten gesunken. Dadurch konnte auch während des Traffics zum Black Friday, der um 300 Prozent höher gewesen war als im Vorjahr, 100 Prozent Uptime aufrechterhalten werden. Somit sei mit Splunk Observability Lenovos operative Effizienz, die Zusammenarbeit im Team und die Zeit für die Fehlerbehebung erheblich verbessert worden.

* Der Autor Matthias Maier ist Data Evangelist bei der Splunk Services Germany GmbH.