Google Cloudが2023年に発表した「Gemini」は、マルチモーダル基盤モデルの新たな境地を切り開く。テキスト、画像、音声、動画、コードといった多様な情報をシームレスに扱うこのモデルは、シンプルな説明から複雑な推論まで幅広いタスクに対応可能。この新たな基盤モデルの企業のクラウド基盤への応用の可能性を深掘りする。

Geminiの革新的な特徴とマルチモーダル性能

(左より)グーグル・クラウド・ジャパン合同会社 統括技術本部長(アナリティクス / ML、データベース)寳野雄太氏

グーグル・クラウド・ジャパン合同会社 AI/ML 事業開発部長 下田倫大氏

Google Cloud Applied AI Summitに先立つ2023年12月6日(現地時間)、Google Cloudはマルチモーダル基盤モデルとしてゼロから同社が構築した「Gemini」を発表した。Geminiは、テキストからテキスト、テキストから画像のようなシングルモーダル基盤モデルを組み合わせて構築する既存のマルチモーダル基盤モデルとは異なる。寳野氏の説明によれば、「テキスト、画像、音声、動画、コードなど、様々な種類の情報をシームレスに理解し、操作し、組み合わせて結果を出力する『ネイティブなマルチモーダル基盤モデル』である」という。この特徴により、Geminiを使うことで、画像の説明のような単純なタスクではなく、もっと複雑で抽象的な概念を扱う推論への適用が可能になった。

Geminiのモデル構造:NanoからPro、Ultraへ

Geminiには小さい順にNano、Pro、Ultraの3つのサイズがある。Nanoがスマートフォンなどのエッジデバイス向け、Proが組織の幅広いタスクに対応する中核モデル、Ultraが数学、物理学、歴史、法律、医学、倫理などの知識と問題解決能力を備えた最上位のモデルになる。Google Cloudはこれまでも複数の選択肢の中から、ユースケースに応じて最適なものを選択できるようにしてきたが、今回のGeminiの発表で、その選択肢がさらに増加したことになる。また、Bardを支えるという意味では、「英語版のBardでGemini Proが利用可能になったという発表があった」と寳野氏は説明した。

図1:新しい基盤モデルGeminiの特徴 出典:グーグル・クラウド・ジャパン [画像クリックで拡大]

Gemini開発環境:Google AI StudioとVertex AI

とはいえ、基盤モデルはそのままでは使えない。開発者向けにGeminiを使える環境として、Google Cloudが用意しているのがGoogle AI StudioとVertex AIの2つである。Google AI Studioは、無料で利用できる個人向けの開発環境で、APIキーを利用してプロンプトを開発できる。もう1つのVertex AIはもっと高度なエンタープライズ要件に対応する開発環境で、Google Cloud Applied AI Summitでは新しくGemini Proのサポートを開始したことが発表になった。「どちらの環境でもGeminiを使えるが、Vertex AIの方がより幅広いユースケースでの利用を想定しており、データ保護のようなエンタープライズ要件に対応する必要がある場合は、Vertex AIを選ぶことを推奨している」(寳野氏)。

図2:Google AI StudioとVertex AIの違い 出典:グーグル・クラウド・ジャパン [画像クリックで拡大]

AIワークロードの高速化と最新TPUテクノロジー

Vertex AIは生成AIを組み込んだアプリケーションを開発するための環境であるが、それを支えるインフラにも大きな進化があった。Google Cloudは2015年からAIワークロードを高速化することを目的に、TPU(Tensor Processing Unit)という特定用途向け集積回路(ASIC:Application Specific Integrated Circuit)を提供してきた。2023年に入ってからの生成AIブームの影響で、世界的にGPU不足の問題が顕在化しているが、Google Cloudの場合、AIファーストの時代が来ることを見越して、いち早く半導体開発戦略を推進してきたことになる。

TPU v5pの革新性と性能向上

最新のTPUは第5世代。Google Cloud Applied AI Summitでは、Geminiの発表と同時に新しい「TPU v5p」の発表があった。後ろの「p」は性能を表し、TPU v4からTPU v5pへの性能向上で、既存モデルのトレーニングが2.8倍高速になり、スケーラビリティは4倍、チップあたりのFLOPSが2倍になった。TPU v5pはGeminiのトレーニングでも用いられた。

TPU v5eのコスト効率とGemini Proの価格設定

また、このTPU v5p は、8月末に発表した「TPU v5e」を基に開発されたものでもある。こちらの「e」は効率性を示し、TPU V5eとTPU v4のコスト効率を1米ドルあたりで比較したとき、トレーニングのパフォーマンスで2倍、推論のパフォーマンスで2.7倍になった。このコスト効率向上は、顧客が求めるAIインフラの最適化ニーズに応えてのもので、価格を抑えてのGeminiの提供と既存の基盤モデルの値下げに貢献する形になった。寳野氏は、「Gemini Proの提供価格は、2023年6月におけるPaLM 2の提供価格と比べ、入力文字数あたりの単価を4倍安く、出力文字数あたりの単価を2倍安く設定できた。同時に、既存のモデルであるPaLM 2の値下げも実現できた」と説明した。

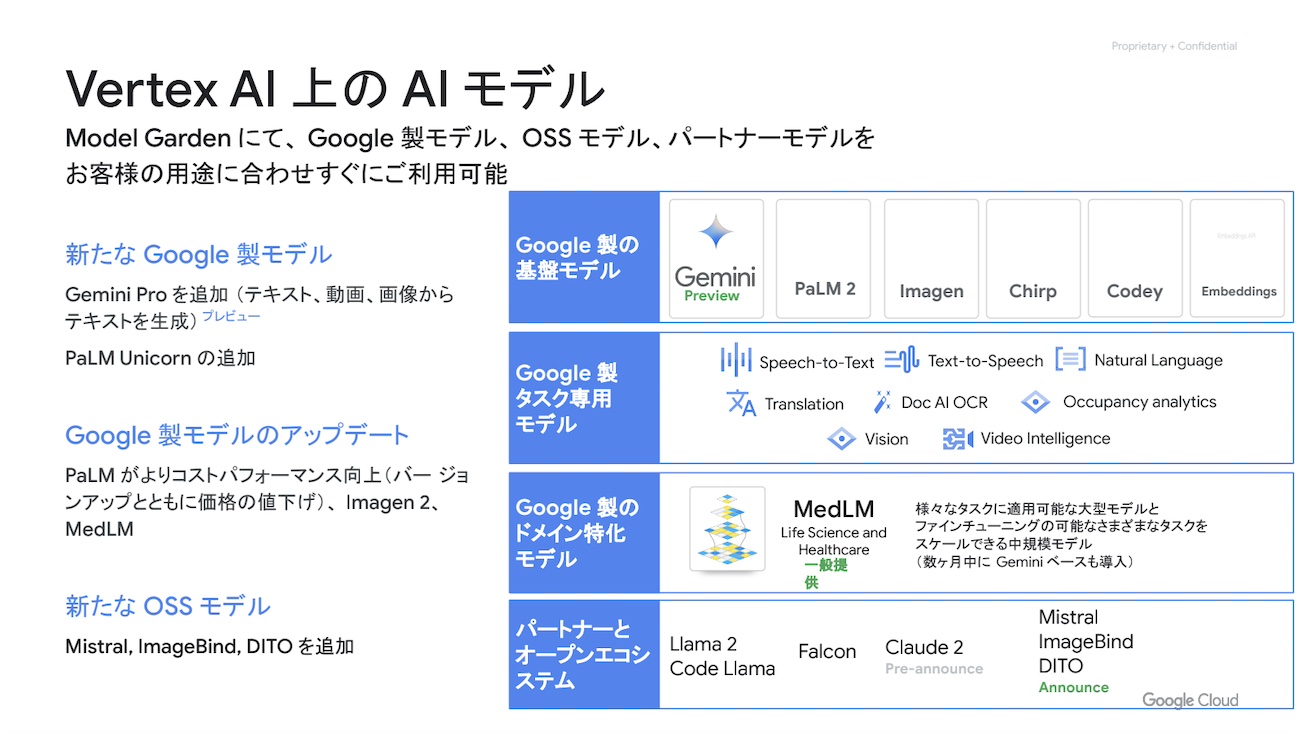

Gemini Ultraのプレビュー開始とModel Gardenの展開

Gemini Proは、Google Cloud Applied AI Summitと同時にVertex AI Model Gardenで一般利用開始になった。最上位のGemini Ultraはプライベートプレビューを開始したところだが、開発者はユースケースに合わせて最適な基盤モデルをModel Gardenから選ぶことができる。

Model Gardenの基盤モデル更新とPaLM 2のサイズ選択

Gemini以外でも、Model Gardenで利用可能な基盤モデルには多くのアップデートがあった。まず、PaLM 2ではサイズの選択が可能になった。PaLM 2には、サイズの小さい順にGecko、Otter、Bison、Unicornの4つが用意されており、Model Gardenには最も大きいUnicornが追加された。次に、画像生成のImagen 2でもテキストレンダリングやテキストオーバーレイ機能の強化で、ロゴ画像生成が可能になるなどの改良が加えられてもいる。この他、OSSの基盤モデルとしてMistral、ImageBind、DITTOも利用可能になった。

最後に寳野氏が強調したのが、「Gemini、PaLM2、Imagenの3つを対象に、企業が安心して生成AIを組み込んだアプリケーション開発ができるよう、法的リスクに備えた補償範囲を拡大したこと」だ。もし企業がこれらのモデルを使って出力したコンテンツが著作権侵害に当たると訴えられた場合、その責任は利用企業ではなく、Google Cloudが負うことになる。その対象は、モデルを使った出力結果だけでなく、トレーニングに使うデータも含まれるのがポイントだ。

Vertex AIとAI駆動アプリケーション開発の進化

続いて登場した下田氏は、生成AIアプリケーション開発のサポートに関係するアップデートを紹介した。まず、開発者からの要望が多かった機能の1つ、Vertex AI Function Callingが一般提供開始になった。この機能は、任意のアクションを関数として定義し、登録しておくことで、基盤モデルが対話の中で必要となる関数を選択し、実行できるようにするもので、コード生成と実行のようなユースケースなどでの利用を想定している。

次に、Vertex AI Extensionsがプライベートプレビューで利用可能になった。この拡張機能は、社内データソースや外部のサードパーティデータサービスにアクセスしてのタスクの実行をサポートするものになる。下田市によれば、「Vertex AI Extensionsの利用で、API経由で大規模言語モデルが外部のデータソースに接続し、入力内容の文脈により即した出力結果を返すことができるようになる」という。また、データソースの拡張に加え、ハルシネーション対策に有用なアプローチの1つ、グラウンディングを実現するGrounding in Vertex AIも一般提供開始になった。ピンポイントで適切なデータにグラウンディングするだけでなく、Grounding in Vertex AIでは、出力回答がどのようなデータを参照したかを確認し、回答のファクトチェックができるようにもしている。

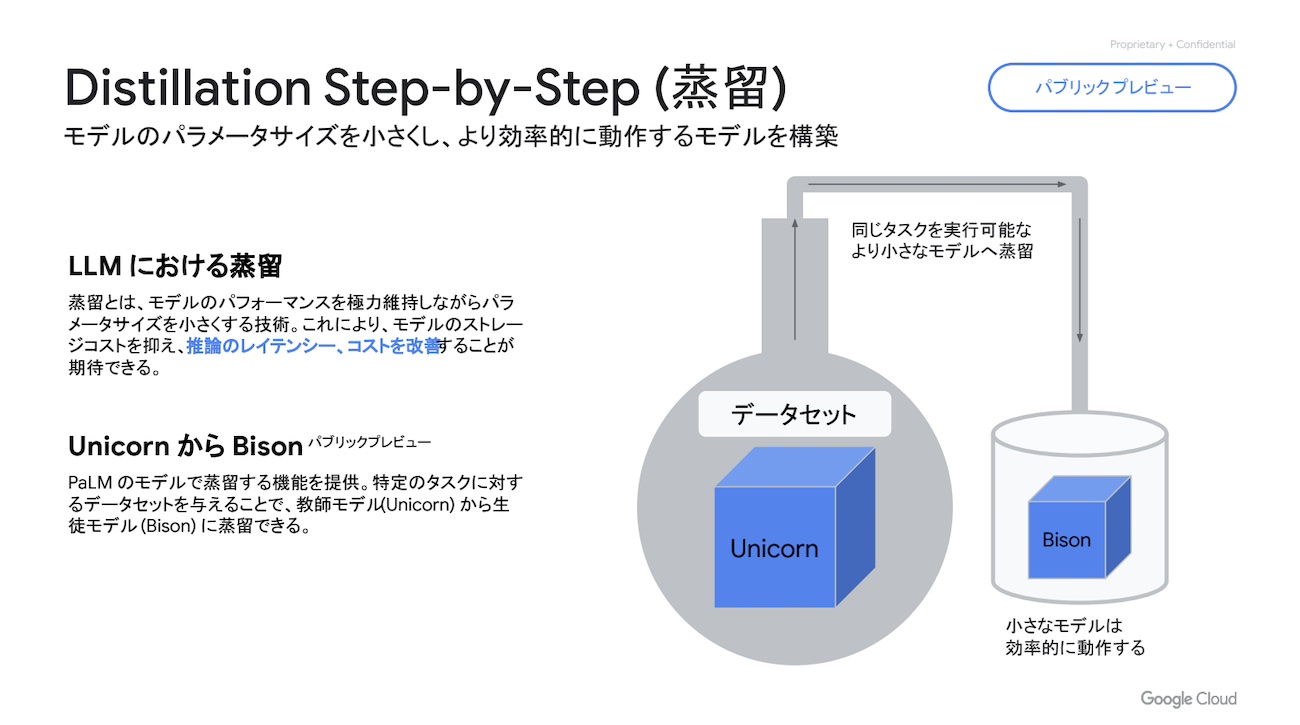

新機能「Distillation Step-by-Step(蒸留)」

この他、Google Cloud Applied AI Summitで開発者向けに新しく発表になった新機能に、Distillation Step-by-Step(蒸留)がある。生成AIの世界における蒸留とは、パラメーターサイズの大きな教師モデルを利用し、パラメーターサイズの小さな生徒モデルを構築する技法のことを指す。下田氏は、「蒸留で作られた基盤モデルは、教師モデルの特徴を維持しながらも、より軽量で効率的に動作するモデルになる」と解説した。

Vertex AI Search & Conversationsの強化とGeminiの展開

基盤モデルのサイズは大きければ大きいほどよいとは限らない。モデルのサイズが大きければ、処理に時間がかかるし、アプリケーション運用コストも高額になる。だとすると、ユースケースによって最適な大きさのものにすることが望ましい。蒸留でサイズを小さくしながらも、大きいモデルと同じパフォーマンスを得られるのであれば、コスト効率の向上やタスク実行のスピードアップのメリットが得られる。PaLM 2のUnicornから1段階小さいBisonへの蒸留の一般利用を開始したのは、最適化を求める顧客ニーズに対応する意図がある。

Gemini対応が進むVertex AIとDuet AI

Vertex AI Search & Conversationsの新機能とGemini対応

Vertex AIでは、検索アプリケーションと会話エージェントを数時間から数日程度で構築できるVertex AI Search & Conversationsを提供している。今回のGoogle Cloud Applied AI Summitでは、これら2つのローコード開発サポート機能がGeminiで強化されることも明らかになった。時期は2024年の早いタイミングになるという。Gemini Proに対応することで、より検索精度の高いアプリケーションの開発、より回答精度の自然な会話エージェントの構築が可能になるとGoogle Cloudでは考えている。

Generative Playbook機能のプライベートプレビュー開始

Vertex AI Conversationでの強化という意味では、Generative Playbook機能がプライベートプレビューで利用開始になったことも役に立ちそうだ。これは自然言語での指示と構造化データをプレイブックという形にまとめて大規模言語モデルに渡せば、エージェントが行うべきフロー、アクションを自動で生成してくれるというもので、従来であれば大きな工数を必要としていたルールベースのシナリオ作成とそのアップデートの負荷が軽減されることになる。

Duet AI for Workspaceの一般提供開始とその機能

最後に寳野氏からは、Duet AI for Workspaceが一般提供開始になったことの紹介もあった。Duet AI for Workplaceは、文章作成やスプレッドシートの改善、会議の議事録作成などをAIベースで支援するアシスタントで、2024年早期のGemini対応を予定している。この展開で、Google Workplace下のGmail、Meet、Docs、Slidesなどのサービスが強化されることになる。寳野氏は、「例えば、手書きの飛行機の絵を入力し、『この飛行機をリアルなイメージにして』と指示を与えると、よりリアルで精細な飛行機の画像を出力してくれる」と、Gemini対応によって可能になることを例示した。

また、Duet AI for DevelopersとDuet AI for Securityも一般提供を開始した。Duet AI for Developersは、AIによるコード補完やコード生成などをサポートするもの。Duet AI for Securityは、MandiantのセキュリティサービスをGoogle Workplaceに取り入れ、セキュリティ担当者の攻撃前の脅威の発見をサポートするものになる。いずれもGeminiが展開されることで、サービス内容の強化が期待できそうだ。

Enjoyed this article? Sign up for our newsletter to receive regular insights and stay connected.